공부하는 단계에서 정리한 내용입니다.

잘못된 내용이 있다면 말씀해주시면 감사하겠습니다.

https://mml-book.github.io/book/mml-book.pdf

4.2 Eigenvalues and Eigenvectors

Graphical Intuition in Two Dimensions

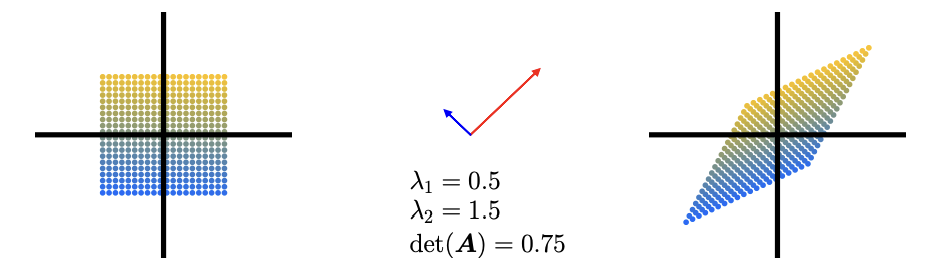

여러 가지 linear mapping을 사용해서 determinant, eigenvector, eigenvalue를 직관적으로 접근해보자.

아래는 5개의 transformation 행렬이 원점을 중심으로 하는 정사각형에 미치는 영향을 각각 나타낸다.

eigenvalue는 변환 후에도 같은 방향으로 남아있는 벡터들의 크기 변화를 나타냄!

e.g. A=[2003] 일 때 고유값은 2,3이고 x축 방향 벡터와 y축 방향벡터가 각각 2배, 3배 확대된다는 뜻

1. A1=[12002]

아래와 같이 계산하면 된다.

eigenvalue는 벡터들의 크기 변화를 나타내고, eigenvector는 백터들의 방향 변화를 나타낸다.

교재의 그림이 깔끔해서.. 넣어보자면 아래와 같다.

아래도 문제1처럼 해주면 된다.

2. A2=[11201]

3. A3=[cos(π6)−sin(π6)sin(π6)cos(π6)]

4. A4=[1−1−11]

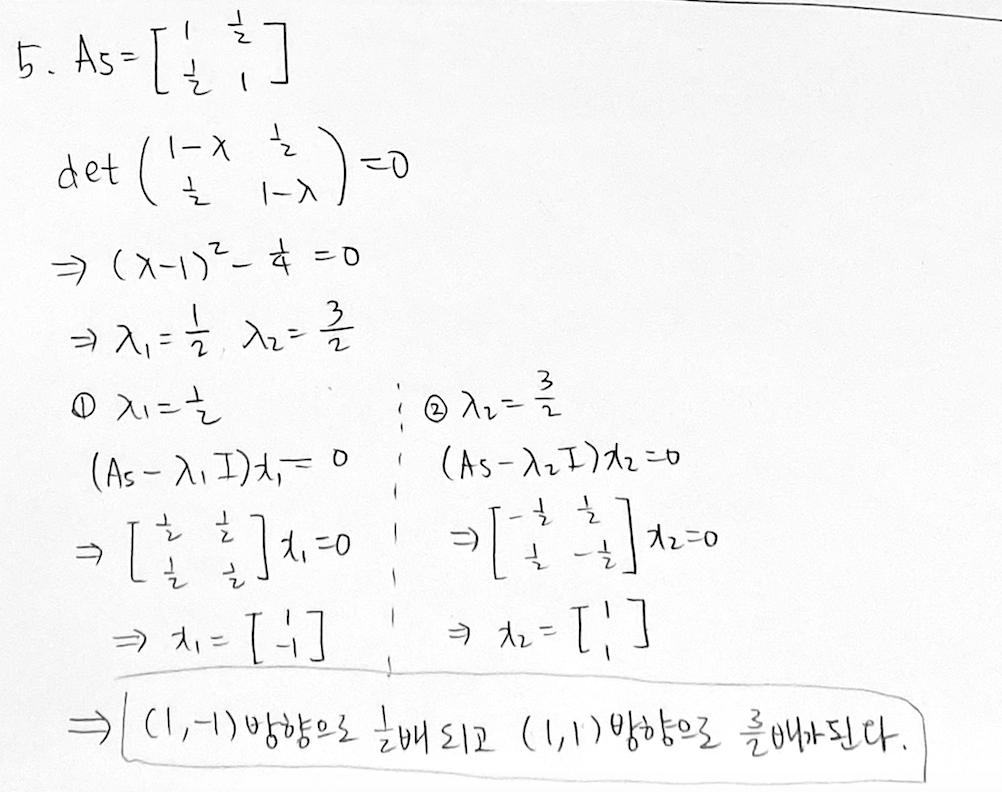

5. A5=[112121]

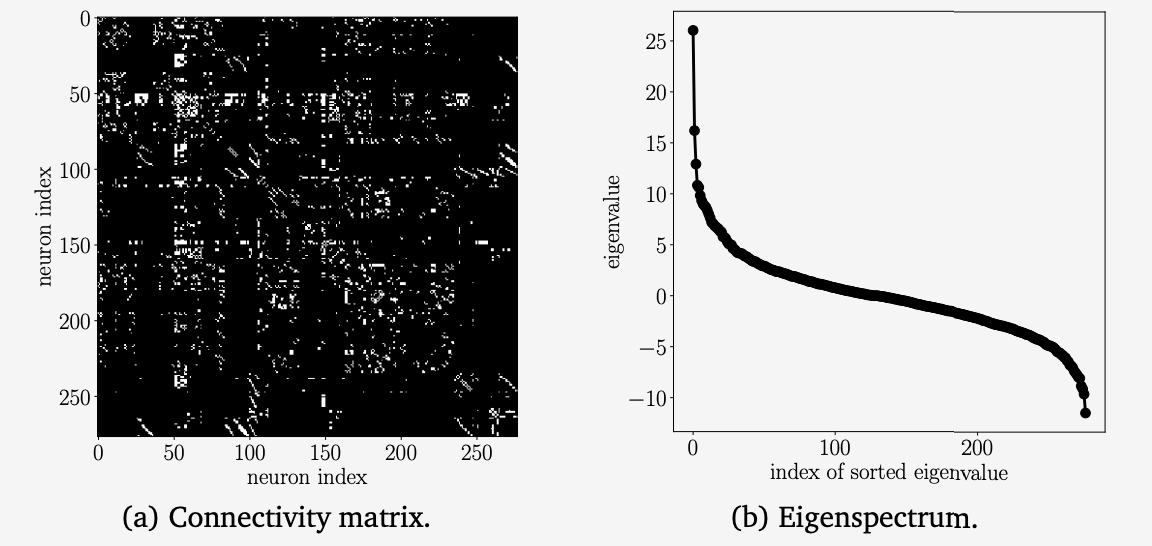

Ex 4.7 (Eigenspectrum of a Biological Neural Network)

네트워크 간의 연결에 대해서 이해할 때 행렬을 사용해서 이해하면 좋다.

여기서는 선충 C. Elegans의 뉴런을 예시로 든다. (227×227크기의 행렬 A)

뉴런 i가 j로 신호를 보낸다고 해서 반대로 j가 i로 신호를 보내는 것은 아니기 때문에 행렬 A 자체는 비대칭 행렬이다.

하지만 우리는 일단 뉴런들끼리 연결되어 있는지 여부만 알면 되고, 비대칭 행렬을 사용하면 계산이 복잡해지므로

대칭행렬 Asym=A+A⊤을 만들어서 뉴런들끼리의 연결 여부만 판단한다.

(a)가 Asym 행렬을 시각화 한 것이다. 흰 부분이 연결된 부분이다.

그리고 이렇게 나온 Asym의 eigenvalue를 내림차순 정렬해서 분석하면 (b)와 같이 S자 그래프 형태를 보인다.

(+ 생물학적 신경망에서 이러한 패턴이 특징적으로 나오는데 그 이유는 아직 밝혀지지 않았다)

Theorem 4.12

n×n행렬 A가 eigenvalue λ1,...,λn를 가지면, 각각의 eigenvector x1,...,xn은 linearly independent하다.

즉, x벡터들이 Rn의 basis들이다.

Def 4.13

만약에 n×n 행렬 A의 eigenvector 개수가 n보다 작으면 A가 defective하다고 한다.

n×n 행렬 A은 n개의 eigenvalue를 가질 필요는 없지만, n개의 eigenvector를 가져야 한다.

Remark.

Def 4.13에서와 같이 defective 행렬은 n개의 서로 다른 eigenvalue를 가질 수 없다. (항상 n개보다 작음)

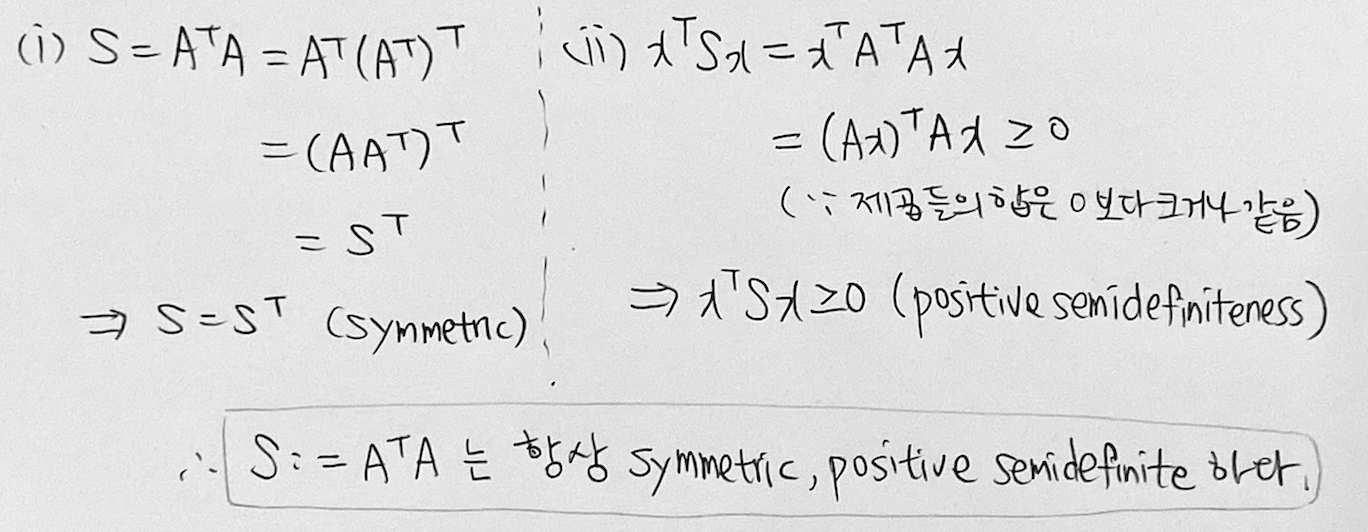

Theorem 4.14

m×n 행렬 A가 있을 때, 행렬 S:=A⊤A는 항상 symmetric, positive semidefinite 하다.

Theorem 4.14 의 symmetric, positive semidefinitness 성질을 아래와 같이 유도할 수 있다.

Remark.

위 식에서 rk(A)=n이라는 조건이 추가로 붙으면, S가 symmetric, positive definite 가 된다.

Theorem 4.15 (Spectral Theorem)

행렬 A가 symmetric하면, eigenvalue는 항상 실수이고 eigenvector는 서로 orthogonal하다.

그리고 eigenvector들을 정규화하면 orthonormal basis가 된다.

Spectral 정리에 의하면 symmetric한 행렬 A는 항상 eigendecomposition이 존재한다.

즉, A=PDP⊤, (P: eigenvector, $D$: diagonal 행렬)들을 열벡터로 갖는 행렬)와 같이 쓸 수 있다.

Ex 4.8

Theorem 4.16

행렬의 determinant는 그 행렬의 모든 eigenvalue를 곱한 값과 같다. 식으로 표현하면 아래와 같다.

det(A)=n∏i=1λi=λ1λ2…λn

Theorem 4.17

행렬의 trace는 그 행렬의 모든 eigenvalue를 합한 값과 같다. 식으로 표현하면 아래와 같다.

tr(A)=n∑i=1λi

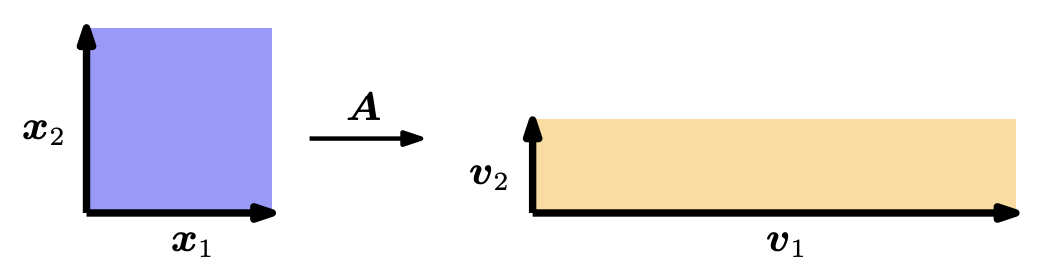

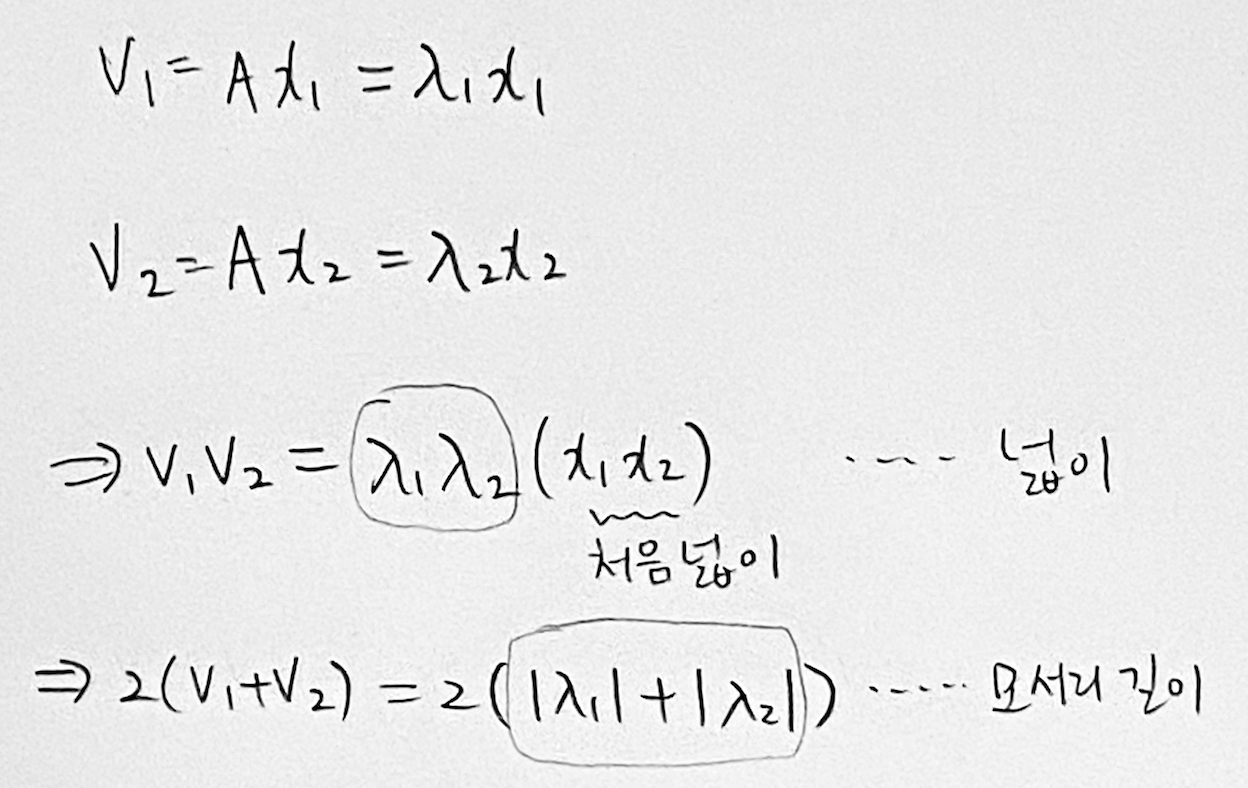

Theorem 4.16과 4.17을 직관적으로 이해해 볼 수 있다.

아래 그림처럼 R2에 linearly independent한 ONB eigenvector x1,x2가 있다고 해보자

행렬 A로 변환을 하기 전과 후의 넓이와 모서리 길이를 아래와 같이 계산할 수 있다.

넓이는 determinant에, 모서리 길이는 trace에 대응된다.

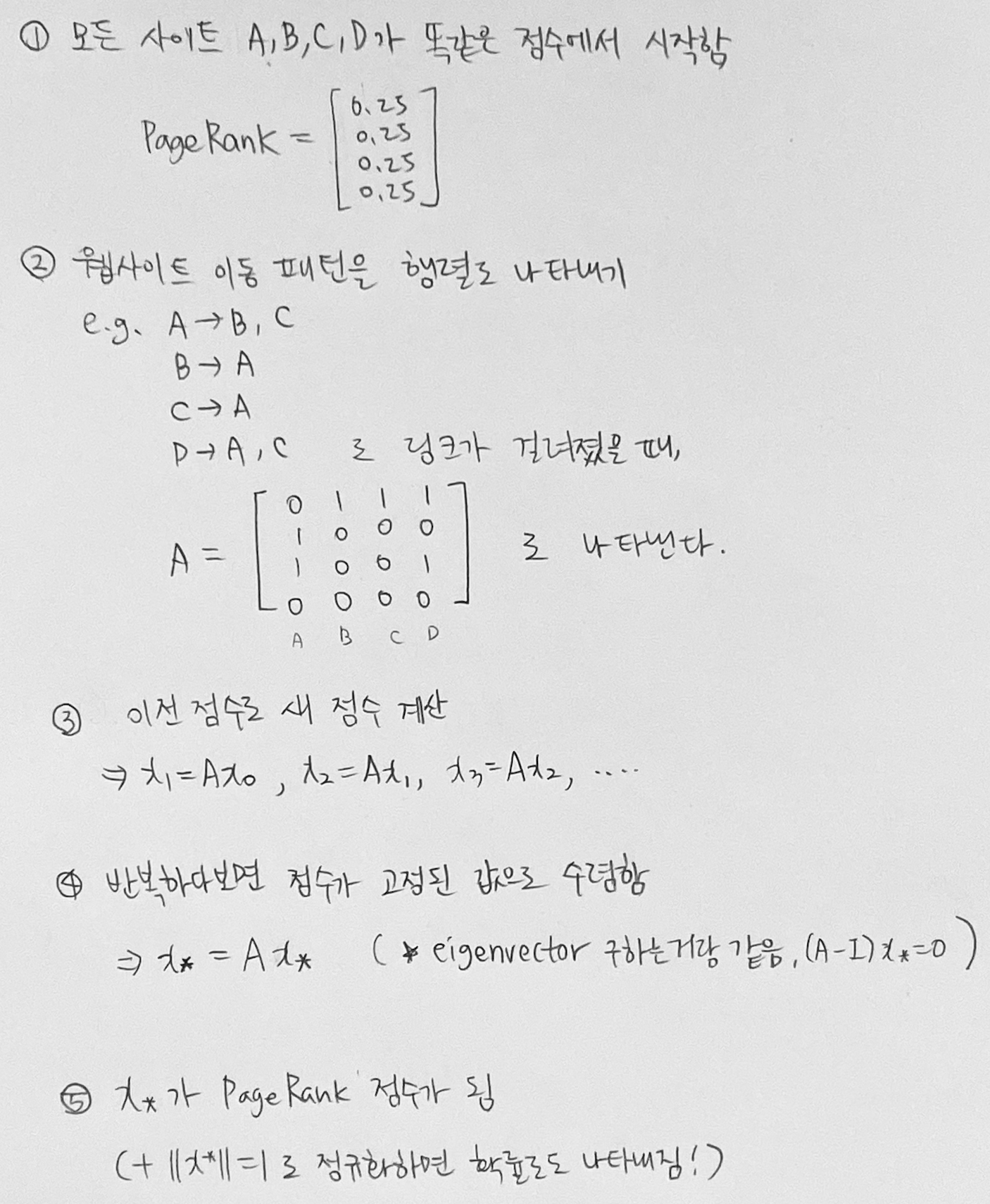

Ex 4.9 (Google's PageRank - Webpages as Eigenvectors)

'웹페이지의 중요도는 그 페이지에 링크를 걸어준 페이지들의 중요도로 근사할 수 있다'고 한다.

.. 와닿지가 않아서 아래와 같이 한스텝 한스텝씩 정리해봤다.

Eigenvalue랑 eigenvector 끝...