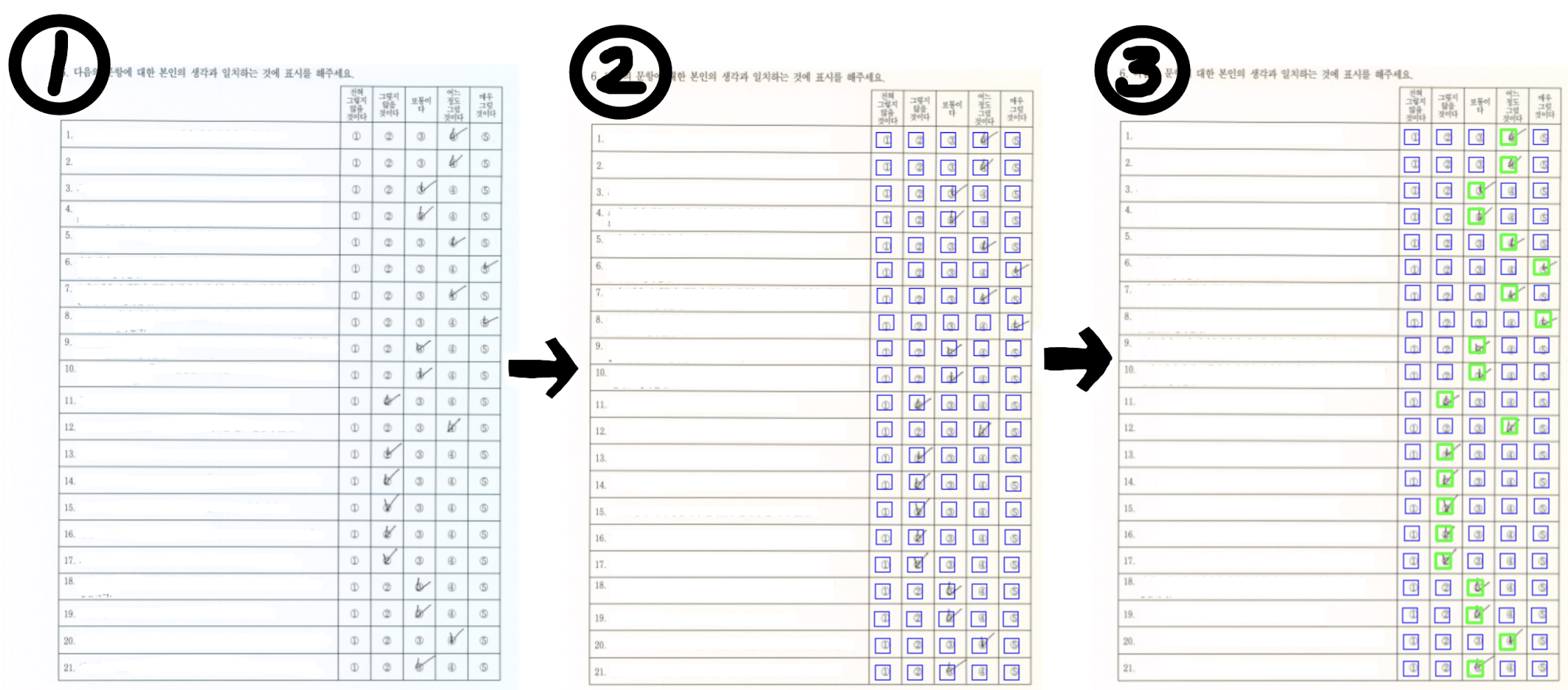

설문지 응답 검출 프로그램 제작(with Python) ~ 목차 ~1. 개요 1.1 기간 1.2 TASK 1.3 문제점 1.4 목표2. 데이터 2.1 구성 2.2 특징3. 프로세스4. 이슈와 해결방법 4.1 bbox 위치·크기 설정의 애매함 4.2 응답 색의 다양함 4.3 과하게 연한 응답 존재5. 결과6. 회고 1. 개요 1.1 기간 - 총 3일 (24.7.30. - 24.8.1.) 1.2 TASK - 학과 대학원 연구실에서 설문지로 진행한 설문조사의 응답을 전산상에 입력해야 했다. 1.3 문제점 - 기존에는 응답 데이터를 사람이 수기로 입력했는데, 문항에 비례하여 시간이 소요된다는 단점이 있었다. 1.4 목표 - 시간을 절약하기 위해 설문지에서 응답..